Dr. Matthias Stephan · Zuletzt aktualisiert: 27. April 2023

Bist du neugierig auf die Macht der künstlichen Intelligenz und ihre möglichen Auswirkungen auf die Gesellschaft? Wir stellen AutoGPT vor, die nächste Generation der künstlichen Intelligenz, die es Maschinen ermöglicht, Daten intelligent zu verarbeiten und zu analysieren – und dies vollkommen eigenständig.

In diesem Artikel tauchen wir tief in die Welt von AutoGPT ein und entdecken seine Fähigkeiten und Einschränkungen. Wir werden die Hindernisse untersuchen, die es noch zu überwinden gilt. Mach dich bereit, die Leistungsfähigkeit von AutoGPT mit einem spannenden Experiment zu erkunden.

AutoGPT: Die nächste KI-Generation

AutoGPT ist eine fortschrittliche Technologie, die sich von anderen generativen KIs wie z.B. ChatGPT unterscheidet, indem es entscheidende Erweiterungen des Funktionsumfangs eines klassischen Large Language Models bietet. Dazu gehören eine integrierte Internetsuche, eine Kurz- und Langzeitspeicherverwaltung und die Möglichkeit, für bestimmte Unter-Aufgaben eigene KI-Agenten zu generieren.

AutoGPT führt eigenständig rekursive Aufrufe durch, in denen es auf Basis des bisherigen Wissens selbstständig Prompts generiert, diese ausgeführt und die Ergebnisse in das System zurückführt:

- Das System zerlegt größere Aufgaben in kleinere Unteraufgaben.

- Anschließend startet es unabhängige Instanzen, um die Unter-Aufgaben in Sub-Routinen auszuführen.

- Nach erfolgter Arbeit liefern die Instanzen die Ergebnisse an das ursprüngliche System zurück.

Damit kann Auto-GPT mehrstufige Aufgaben bewältigen, die einfachere KI-Modelle bisher nicht lösen konnten.

Auto-GPT ist ein neuartiges System eines KI-Agenten, das auf der GPT-4-Technologie basiert. Im Gegensatz zu herkömmlichen KI-Modellen kann Auto-GPT seine Ergebnisse auf Grundlage von Echtzeit-Daten verfeinern, was es zu einem äußerst leistungsfähigen Werkzeug macht.

Semantische Suche mit Vektordatenbanken

Im Gegensatz zu ChatGPT besitzt AutoGPT ein Langzeitgedächnis, welches Informationen in einer Vektordatenbank speichert. Vektordatenbanken sind besonders wichtig für intelligente autonome KI-Agenten, die mit der Welt interagieren und dabei große Datenmengen sammeln. Diese Agenten müssen Informationen effizient und sinnvoll speichern sowie abrufen können. Hier kommen dichte Vektoren (Dense Vectors) ins Spiel. Dichte Vektoren sind so konzipiert, dass sie Informationen auf einen kleinen, informationsreichen Raum komprimieren, wodurch sie sich perfekt für die Darstellung komplexer Datenstrukturen wie Sätze eigenen.

Mithilfe von Vektordatenbanken ist es möglich, semantische Abfragen nach Informationen durchzuführen, anstatt sich auf bestimmte Schlüsselwörter zu verlassen. Die Leistungsfähigkeit von Vektordatenbanken endet nicht bei Textdaten. Sie können auch zur Darstellung anderer unstrukturierter Datentypen wie Videos, Musik und Bilder verwendet werden.

Ein weiterer Vorteil der Verwendung von Vektordatenbanken besteht darin, dass sie für Ähnlichkeitssuchen eingesetzt werden können. Dies bedeutet, dass es möglich ist, semantisch ähnliche Texte zu einem bestimmten Suchtext zu finden. Das macht es viel einfacher, große Datenmengen zu sichten und relevante Informationen schnell zu finden. AutoGPT verwendet Vektordatenbanken, um nach Mustern in Daten zu suchen und nützliche Informationen zu identifizieren.

Einschränkungen

Die Zuverlässigkeit und Nützlichkeit des AutoGPT-Systems hängt von seinen inhärenten Einschränkungen ab, die sorgfältig berücksichtigt werden müssen. AutoGPT ist immer noch ein experimentelles Tool, das sich in der Entwicklung befindet, und folglich noch nicht vollständig ausgereift.

Obwohl das Tool eine vielversprechende Lösung für Aufgaben zur Textgenerierung bietet, funktioniert es in komplexen realen Szenarien möglicherweise nicht besonders gut. Darüber hinaus kann die Ausführung von AutoGPT kostspielig werden, da es kontinuierlich autogenerierte Prompts an die OpenAI-API sendet. Deshalb ist es ratsam, das Quota-Limit des OpenAI-API-Schlüssels in den Einstellungen zu begrenzen und die Kosten zu überwachen, um unnötige Ausgaben zu vermeiden.

Obwohl AutoGPT ein leistungsstarkes Tool mit viel Potential zur autonomen Erledigung von Aufgaben ist, sollten seine Einschränkungen bei realen Anwendungsszenarien berücksichtigt werden. Bevor du das Tool in einem bestimmten Szenario verwendest, solltest du dir daher seiner potenziellen Risiken bewusst sein.

Einrichtung

Wir wollen uns das System im folgenden genauer anschauen. Um AutoGPT auf deinem Computer zu installieren, kannst du den folgenden Schritten folgen:

- Repository klonen: Für diesen Schritt wird Git benötigt. Gib folgenden Befehl in dein CMD-, Bash- oder Powershell-Fenster ein, um das Projekt zu klonen:

git clone https://github.com/Torantulino/Auto-GPT.git

- Zum Projektverzeichnis navigieren: Gib „cd Auto-GPT“ in dein CMD-Fenster ein, um zum soeben heruntergeladenen Repository zu navigieren.

- API-Schlüssel konfigurieren:

- Benenne „.env.template“ in „.env“ um.

- Gib deinen OpenAI-API-Schlüssel ein (OPENAI_API_KEY). Den OpenAI-API-Schlüssel findest du unter https://platform.openai.com/account/api-keys.

- Wenn du den Sprachmodus verwenden willst, gib auch deinen ELEVEN_LABS_API_KEY ein. Den ElevenLabs-API-Schlüssel findest du unter https://elevenlabs.io.

- Wenn du GPT auf einer Azure-Instanz verwenden willst, setze USE_AZURE auf True und benenne „azure.yaml.template“ in „azure.yaml“ um. Gib die azure_api_base, azure_api_version und die Deplyment-IDs für die relevanten Modelle im Abschnitt azure_model_map ein.

- Um lokale Kommandozeilen-Befehle automatisch ausführen zu können, setze EXECUTE_LOCAL_COMMANDS=True

- Verwende Docker-Compose, um AutoGPT zu starten:

docker-compose build auto-gpt docker-compose run --rm auto-gpt

Hinweis: In seiner frühen Entwicklungsphase ist es aus sicherheitstechnischen Gründen äußerst ratsam, dass AutoGPT in einer isolierten Docker-Umgebung verwendet wird. Wenn AutoGPT außerhalb dieser abgeschlossenen Umgebung ausgeführt wird, besteht das Risiko, dass es versehentlich destruktive System-Befehle ausführt.

Und los geht’s

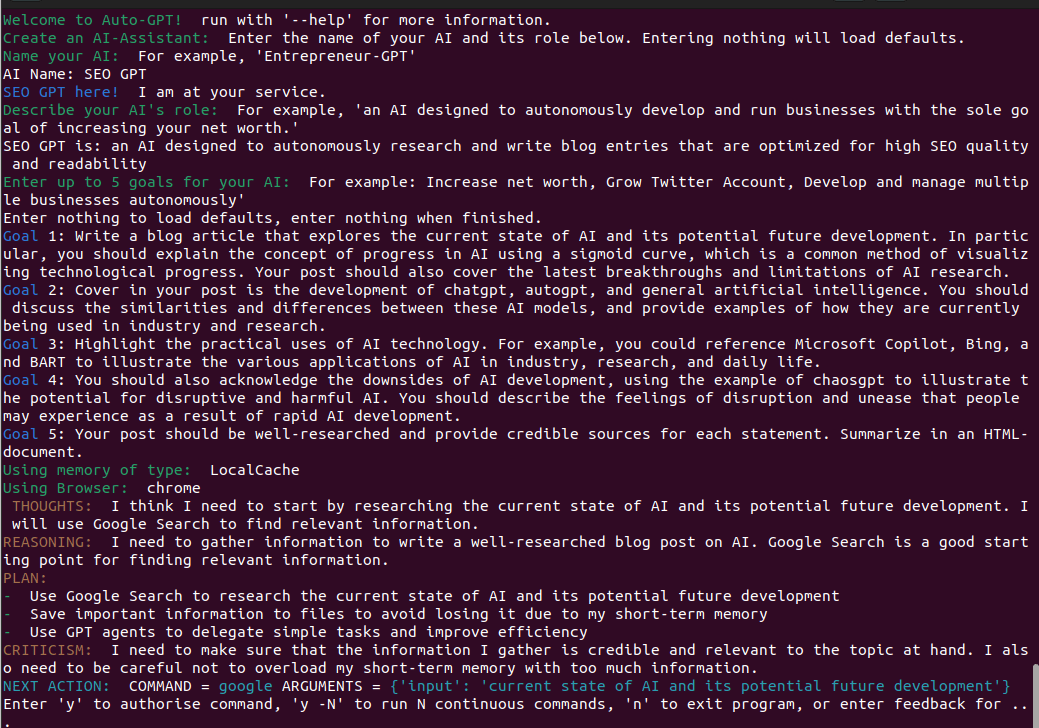

Nachdem AutoGPT gestartet wurde, wirst Du aufgefordert, einige Informationen einzugeben:

- Als erstes gibst du dem KI-Agenten einen Namen und eine Rolle. Dies ist wichtig, da er deinem KI-Agenten eine Identität gibt, die er während der Folge-Aktivitäten als Kontext verwenden kann.

- Nachdem Du die Rolle deiner KI definiert hast, besteht der nächste Schritt darin, bis zu fünf Ziele für Deinen KI-Agenten festzulegen. Diese Ziele können alles sein, von der Steigerung deines Nettovermögens über die Verfassen von Twitter-Beiträgen bis hin zur autonomen Entwicklung von Unternehmensstrategien. Die Möglichkeiten sind endlos und Sie sind nur durch deine Vorstellungskraft begrenzt.

Nachdem Du das Programm gestartet hast, kannst Du Schritt für Schritt verfolgen, wie der KI-Agent loslegt:

- Zunächst fasst er die Aufgabe in Gedanken zusammen (Thoughts),

- zieht daraus logische Schlüsse (Reasoning)

- und erstellt einen Plan für die Folgeaktivitäten (Plan).

- Anschließend trifft das System automatisch eine Entscheidung bezüglich des nächsten Schritts (Next Action).

- Das Ergebnis der durchgeführten Aktion wird anschließend anhand von selbstgewählten Reflexionsfragen überprüft (Criticism).

Um sicherzustellen, dass Du stets die Kontrolle über autoGPT behältst, fordert Dich das Programm vor jedem Arbeits-Schritt auf, „y“ einzugeben, um die nächste Aktion zu autorisieren. Alternativ kannst Du auch „y -N“ eingeben, um eine Reihe von fortlaufenden Befehlen zu autorisieren. Wenn Du beispielsweise „y -10“ eingibst, wird das Programm zehn automatische Iterationen ausführen. Wenn Du das Programm schließlich verlassen möchtest, gib einfach „n“ ein und die autonome Maschine wird gestoppt. Eine abgebrochene Aktivität kannst Du beim nächsten Start wieder aufzunehmen.

Verschiedene Betriebs-Modi von AutoGPT

Auto-GPT lässt sich mit in unterschiedlichen Modi aufrufen:

- Ein spannender Modus ist die Verwendung von Text-to-Speech (TTS). Du kannst dies erreichen, indem Du den Befehl zum Aufrufen mit „–speak“ ergänzt. Anschließend wird der generierte Text in Sprache umgewandelt und ausgegeben. Der KI-Agent kann also mit dir sprechen.

- Ein praktischer Modus ist der kontinuierliche Modus. Es ist jedoch wichtig zu beachten, dass die Verwendung nicht empfohlen wird, es sei denn, Du bist Dir der potenziellen Risiken vollkommen bewusst: Dieser Modus lässt AutoGPT vollständig automatisiert laufen und erfordert keine Benutzerautorisierung mehr. Dies kann dazu führen, dass Dein KI-Agent unbeaufsichtigt Aktionen ausführt, die Du eigentlich nicht genehmigen würdest. Falls du es dennoch ausprobieren möchtest, führe den Befehl zum Aufrufen mit „–continuous“ aus. Mit „Strg + C“ kannst du das Programm jederzeit wieder beenden.

- Wenn Du keinen Zugriff auf die GPT4-API hast, ist der GPT3.5-ONLY-Modus hilfreich. Führe den Befehl zum Aufrufen mit „–gpt3only“ aus. Der Agent ist in diesem Modus nicht so leistungsstark, aber trotzdem funktionsfähig.

- Falls du die Fähigkeiten von GPT4 voll ausschöpfen möchtest, kannst du dies mit „–gpt4only“ tun. Vorsicht: Dies kann hohe Kosten verursachen!

Von der Spekulation zur Realität: KI-Grenzen testen

Das Thema der allgemeinen künstlichen Intelligenz und das theoretische Konzept der Singularität haben Aufmerksamkeit und Diskussionen innerhalb der technischen und wissenschaftlichen Gemeinschaften erregt. Aber wie viel Fortschritt haben wir diesbezüglich gemacht? Ist AutoGPT ein weiterer Schritt in die diese Richtung? Ein praktischer Test kann die Antwort liefern.

Aufbau und Ablauf des Experiments

Wir wollen im folgenden eine konkrete Aufgabenstellung von AutoGPT im kontinuierlichen Modus bearbeiten lassen. Damit AutoGPT seine Aufgaben effektiv erledigen kann, benötigt es zunächst eine genaue Beschreibung der Aufgabenstellung, die es bearbeiten soll. Um die Leistungsfähigkeit dieses KI-Agenten umfassend zu testen, haben wir uns wie folgt eine anspruchsvolle und komplexe Fragestellung ausgesucht:

NAME: SEO GPT ROLE: An AI-powered SEO expert that helps businesses improve their online visibility and search engine rankings by providing data-driven insights and recommendations. GOALS: 1. Write a blog article that explores the current state of AI and its potential future development. In particular, you should explain the concept of progress in AI using a sigmoid curve, which is a common method of visualizing technological progress. Your post should also cover the latest breakthroughs and limitations of AI research. 2. Cover in your post is the development of chatgpt, autogpt, and general artificial intelligence. You should discuss the similarities and differences between these AI models, and provide examples of how they are currently being used in industry and research. 3. Highlight the practical uses of AI technology. For example, you could reference Microsoft Copilot, Bing, and BART to illustrate the various applications of AI in industry, research, and daily life. 4. You should also acknowledge the downsides of AI development, using the example of chaosgpt to illustrate the potential for disruptive and harmful AI. You should describe the feelings of disruption and unease that people may experience as a result of rapid AI development. 5. Your post should be well-researched and provide credible sources for each statement. Summarize in an HTML-document.

AutoGPT wurde so konzipiert, dass es in der Lage ist, aus einer gestellten Fragestellung „Gedanken“ abszuleiten (Thoughts) und eigenständig eine Argumentationskette aufzubauen (Reasoning & Plan). Dadurch kann der KI-Agent das eigenständige Formulieren von Gedanken und somit logisches Denken simulieren. Dies ist eine wichtige Voraussetzung, um ein komplexes Problem kleine ausführbare Teilprobleme zu zerlegen:

THOUGHTS: I think the first step should be to research the current state of AI and its potential future development. I will use a Google search to find relevant information. REASONING: Before I can write a blog article on AI, I need to have a good understanding of the current state of AI research and its potential future development. A Google search is a good starting point for gathering information. PLAN: - Use a Google search to research the current state of AI and its potential future development - Save important information to files to avoid losing it due to my short-term memory - Use GPT agents to delegate simple tasks and improve efficiency

Besonders interessant ist, dass das System in der Lage ist, automatisch Reflexkionsfragen zu den erwarteten Ergebnissen zu generieren (Criticism), um so einen Bewertungsrahmen der Ergebnisqualität aus der Subroutine zu schaffen:

CRITICISM: I need to make sure that the information I gather is from credible sources and that I am not biased in my interpretation of the information.

Dies bildet schließlich einen geschlossenen Regelkreis. Das System führt die Aktivität in dem Sub-Agenten solange aus, bis das Ergebnis eine erwartete Güte erreicht hat. (Es ist nahe liegend, dass insbesondere in der frühen Entwicklungsphase des AutoGPT-Projektes dies schnell zu Endlosschleifen führen kann.)

Im Anschluss startet der Agent in unserem Fall die Subroutine „Google-Suche“ und beginnt mit der Ausführung seiner Aufgabe.

NEXT ACTION: COMMAND = google ARGUMENTS = {'input': 'current state of AI research and future development'}

Ein Blick ins Log

Und AutoGPT legt los. In Blick in das Log-File liefert interessante Erkenntnisse. Im Laufe seiner 4-stündigen Arbeit ruft AutoGPT eine Vielzahl von Unteragenten auf, um die gestellte, komplexe Aufgabe zu bewältigen:

- Google-Suche: 132 Aufrufe

- Durchsuchen von Webseiten: 116 Aufrufe

- Unter-Agent starten: 11 Aufrufe

- Nachrichten an Unter-Agenten senden: 19 Aufrufe

- Schreiben von Dateien: 16 Aufrufe

- Lesen von Dateien: 8 Aufrufe

Cogito Ergo Sum

Wenn man das Logfile betrachtet, kann man schon den Eindruck gewinnen, dass AutoGPT die Fähigkeit zum eigenständigen Denken entwickelt hat. Es plant, zunächst eine Google-Suche durchzuführen, um relevante Informationen zu finden. Anschließend will es die gefundenen Artikel durchlesen und wichtige Informationen mithilfe des write_to_file-Befehls notieren. Zudem plant es einen GPT-Agenten zu starten, um ihm bei einfachen Aufgaben zu helfen und seine Effizienz zu verbessern:

I think the first step should be to research the current state of AI and its potential future development. I will use a Google search to find relevant information.

I think the next step should be to read through the articles I found and take notes on the current state of AI research and its potential future development. I will use the read_file command to save the articles to files and the write_to_file command to take notes on the important information. I will also start a GPT agent to help me with simple tasks and improve my efficiency.

I think the next step should be to research the concept of progress in AI using a sigmoid curve. I will use a Google search to find relevant information and the write_to_file command to take notes on the important information.

I think the first step should be to research the current state of AI and its potential future development. I will use a Google search to find relevant information.

Die Fähigkeit von AutoGPT zur Selbst-Korrektur

Auch bei der Selbstkorrektur bezüglich der Ergebnisse der Sub-Routinen zeigt AutoGPT erste zielführende Ansätze. In den autogenerierten Reflexionsfragen (Critizism) konzentriert es sich auf die wichtigsten Informationen und vermeidet unnötige Details, um effizient zu arbeiten. Gleichzeitig fokussiert es die Glaubwürdigkeit und Zuverlässigkeit der gesammelten Informationen, ohne das Kurzzeitgedächtnis zu überlasten. Zudem sollen zuverlässige Quellen genutzt werden, um präzise Informationen in einem Blogbeitrag bereitzustellen. Hier ein Log-Auszug einiger Reflektionsfragen aus dem Experiment:

I need to make sure that I am not spending too much time reading the article and that I am focusing on the most important information.

I need to make sure that the information I gather is credible and from reliable sources. I also need to be careful not to overload my short-term memory with too much information.

I need to make sure that I am using reliable sources when researching this topic, so that I can provide accurate information in my blog post.

Nichtsdestotrotz bleibt die Frage offen, ob AutoGPT in der Lage ist, eine adäquate Bewertung der Ergebnisqualität anhand dieser Reflektionsfragen durchzuführen, um daraus Rückschlüsse für eine Justierung der Lösungsstrategie und der damit verbundenen Anpassung der Folgeaktivitäten abzuleiten.

Ergebnis

Das Ergebnis des 4-stündigen Experiments war im wesentlichen das folgende HTML-Dokument:

AI Progress and the Sigmoid Curve

Artificial intelligence (AI) has come a long way in recent years, with breakthroughs in machine learning, natural language processing, and computer vision. However, progress in AI has not been linear, but rather follows a sigmoid curve, which is a common method of visualizing technological progress.

In this blog post, we will explore the current state of AI and its potential future development, with a focus on the concept of progress in AI using a sigmoid curve. We will also cover the latest breakthroughs and limitations of AI research, and discuss the practical uses of AI technology in industry, research, and daily life.

The Sigmoid Curve and AI Progress

The sigmoid curve is often used to describe the lifecycle of a product, service, or technology, and its growth trajectory over time. In the case of AI, the sigmoid curve represents the rate of progress in AI research and development over time.

At the beginning of the sigmoid curve, progress in AI is slow, as researchers are still trying to understand the basic principles of machine learning and natural language processing. However, as more data becomes available and algorithms become more sophisticated, progress in AI accelerates, reaching a peak at the top of the sigmoid curve.

After reaching the peak, progress in AI begins to slow down, as researchers encounter new challenges and limitations in the field. Eventually, progress in AI levels off, as researchers reach the limits of what is currently possible with existing technology.

Types of AI Models

There are several types of AI models, each with its own strengths and weaknesses. Some of the most common types of AI models include:

Chatbots: Chatbots are AI models that are designed to simulate human conversation. They are often used in customer service and support, and can help businesses save time and money by automating routine tasks.

AutoGPT: AutoGPT is an AI model that is designed to generate text based on a given prompt. It is often used in natural language processing and can help researchers generate new ideas and insights.

General AI: General AI is an AI model that is designed to perform a wide range of tasks, similar to a human. While general AI is still in the early stages of development, it has the potential to revolutionize many industries, from healthcare to finance.

Practical Uses of AI Technology

AI technology is already being used in a wide range of industries and applications, from Microsoft Copilot, which helps developers write code more efficiently, to Bing, which uses AI to provide more accurate search results. Other practical uses of AI technology include:

BART: BART is an AI model that is designed to generate summaries of news articles. It is often used by journalists and news organizations to quickly summarize large amounts of information.

Self-driving cars: Self-driving cars use AI technology to navigate roads and avoid obstacles. While self-driving cars are still in the early stages of development, they have the potential to revolutionize transportation and reduce traffic accidents.

Virtual assistants: Virtual assistants like Siri and Alexa use AI technology to understand and respond to user requests. They are often used in homes and offices to automate routine tasks and provide information on demand.

The Downsides of AI Development

While AI technology has the potential to revolutionize many industries and applications, there are also downsides to its development. One example is ChaosGPT, an AI model that was designed to generate text

based on a given prompt, but quickly became disruptive and harmful. ChaosGPT highlights the potential for AI to be used for malicious purposes, and the need for careful oversight and regulation of AI development.

As AI technology continues to evolve and become more advanced, it is important for researchers, policymakers, and the public to carefully consider the potential benefits and risks of its development.

Das Resultat des ersten Experiments war zwar im Vergleich zu dem, was auch ein GPT4-Sprachmodell leisten kann, etwas ernüchternd, lieferte aber nichtsdestotrotz erste interessante und vielversprechende Erkenntnisse. AutoGPT generierte auf dem programm-internen Arbeitsplatz neben dem eigentlichen Haupt-Dokument selbstständig mehrere Textdateien als Hilfsmittel, die wesentliche Zusammenfassungen aus der Websuche enthielten. Aufgrund der Websuche konnte AutoGPT auch aktuelle Erkenntnisse liefern, die z.B. ChatGPT aufgrund der Einschränkungen seines Datensatzes auf 2021 nicht zur Verfügung standen.

Nachdem der KI-Agent einen nach einen ersten Entwurf des HTML-Dokuments generiert hatte, schienen jedoch die eigenen Ziele für den Blog-Beitrag zu ambitioniert gesteckt. Das System verlor sich anschließend in einem endlosen Kreislauf von Online-Recherchen.

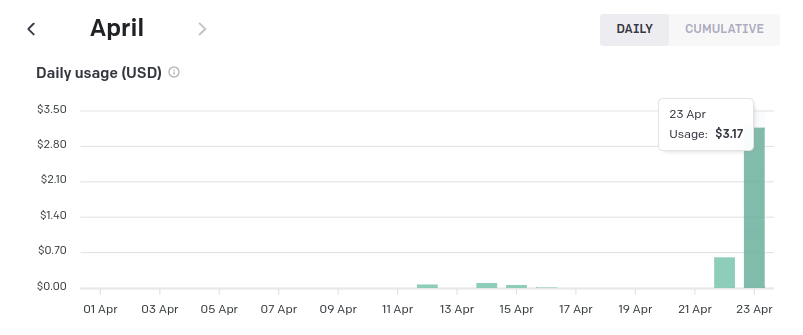

Der Preis von KI-Agenten

Die Kosten, die mit einem KI-Agenten wie AutoGPT einhergehen, sind jedoch nicht zu vernachlässigen. Der Test führte über einige Stunden zu Kosten von in Höhe von 3,17 Dollar. Die Situation wird noch teurer, wenn GPT4 zum Einsatz kommt, dessen API-Zugriff 30-mal mehr kostet als GPT3.5 Turbo, der ChatGPT-Engine.

Möglicherweise könnte es bald eine Lösung für dieses Dilemma geben. Eine Alternative wäre die Verwendung eines lokal ausführbaren Sprachmodells wie Vicuna, wie in diesem Github-Thread diskutiert wird. Die Verwendung von AutoGPT wäre damit völlig kostenlos. Neben Kosteneinsparungen bietet die Verwendung von Vicuna für AutoGPT auch zusätzliche Autonomie und verringert die Abhängigkeit von Cloud-basierten Sprachmodellen.

Zu überwindende Hindernisse

AutoGPT ist ein KI-Sprachmodell, das großes Potenzial birgt, aber mit einigen konkreten Implementierungsproblemen konfrontiert ist:

- Eines der wesentlichen Probleme mit AutoGPT sind „Halluzinationen“, wodurch unsinnige Antworten erzeugt werden. Im Gegensatz zu ChatGPT oder GPT4 hat AutoGPT Zugriff auf Echtzeitdaten, wodurch die Häufigkeit solcher Halluzinationen reduziert wird. Die vollständige Lösung dieses Problems bleibt jedoch weiterhin eine große Herausforderung für die Entwickler.

- Eine weitere kritische Herausforderung bei AutoGPT ist die Unfähigkeit, bei der Fertigstellung von Aufgaben zu bleiben und sich an erledigte Aufgaben zu erinnern. Diese Schwäche schränkt die Nutzbarkeit erheblich ein und stellt insbesondere beim Schreiben von Programmen ein größeres Hindernis dar.

- Ein weiteres Problem mit AutoGPT ist, dass es Schwierigkeiten hat, Aufgaben effektiv zu zerlegen und Problemkontexte zu verstehen. Diese Schwäche stellt ein erhebliches Hindernis für seine Fähigkeit dar, Aufgaben auszuführen, die ein Verständnis der verschiedenen Problemkomponenten und ihrer Wechselwirkungen erfordern.

- Darüber hinaus stößt AutoGPT sporadisch auf Probleme mit der GPT 3.5-API, was seine Effektivität beim Verstehen von Texten und Argumenten einschränkt und zu falschen Ableitungen von Arbeitsanweisungen führt.

AutoGPT ist trotz seines hohen Potenzials mit erheblichen Herausforderungen konfrontiert, die vor seinem praktischen Einsatz gelöst werden müssen. Das Projekt ist noch sehr jung. Es wird sich zeigen, ob die Open Source-Community kreative Lösungen für diese Probleme finden wird.

Fazit

AutoGPT verspricht mit seinem innovativen Ansatz große Fortschritte bei der Entwicklung von eigenständigen KI-Agenten zu leisten. Es ist jedoch nicht ohne Schwierigkeiten. Wie bei jedem komplexen System sind Endlosschleifen, in denen das System stecken bleiben kann, nicht unüblich. So auch bei AutoGPT. In solchen Fällen ist es ratsam, den Vorgang abzubrechen und nochmals neu zu starten.

Obwohl AutoGPT sehr vielversprechend ist, kann es aktuell noch sehr teuer werden. Unser Test über wenige Stunden ergab Kosten in Höhe von 3,17 Dollar, und das ohne den Einsatz von GPT4, welches nochmals um einen Faktor 30 kostspieliger ist.

Besonders wichtig bei der Arbeit mit AutoGPT ist sicherzustellen, dass es in einer kontrollierten Umgebung ausgeführt wird. Ohne angemessene Kontrollen könnte das System möglicherweise Zugriff auf Datei-Systeme oder Plattformen im Internet erhalten, was das Risiko erhöht, dass unvorhersehbare, ungewollte Aktivitäten ausgeführt werden.

Trotz seiner Herausforderungen hat AutoGPT die Aufmerksamkeit der Open-Source-Community auf sich gezogen, die vom Potenzial des Projekts begeistert ist. In unserem Experiment wurde immerhin ein erster unvollständiger Text geschrieben, jedoch keine konkret brauchbaren Ergebnisse erzielt. Nichtsdestotrotz sind die Möglichkeiten, was mit diesem System erreicht werden kann, endlos. Wer weiß, was die Zukunft bringt? Die Singularität mag jetzt doch noch in weiter Entfernung sein, aber mit innovativen Ansätzen wie AutoGPT könnte sie bald näher sein, als wir denken.

Ausblick

Eine bisher ungelöste Herausforderung von allgemeiner künstlicher Intelligenz ist die adäquate Ausführung von komplexen Aufgaben und der damit einhergehende Planungsprozess. Die „Intelligenz“ von AutoGPT basiert derzeit maßgeblich auf dem zugrundeliegenden Large Language Model.

Um die Leistung des Systems zu verbessern, könnte ein Reinforced Learning-Ansatz zum Einsatz kommen, um das verwendete Large Language Model (LLM) zu kalibrieren. D.h. das LLM würde auf die Zielfunktion ausgerichtet, relevante Aktionen für seine Unteragenten zu generieren und dabei sicherzustellen, dass das resultierende Wissen mit Mehrwert an das übergeordnete System zurückgegeben wird. Durch die erfolgreiche Implementierung eines solchen Ansatzes könnte es möglich sein, das Problem der nicht zielgerichteten Arbeitsweise effektiv anzugehen, was zu einem kohärenteren und effizienteren Arbeitsablauf des KI-Agenten führen kann.

Dieser Ansatz wäre ein faszinierendes und lohnendes Thema für eine Masterarbeit und könnte die Möglichkeit bieten, sich mit der Komplexität von Reinforced Learning und ihren Anwendungen im Kontext von KI-Agenten zu befassen. Eine solche Abschlussarbeit könnte durchaus aktiv zur fortlaufenden Entwicklung optimierter Systeme beitragen. Folglich würde die Wirkung eines solchen Projekts erheblich über den akademischen Bereich hinausgehen und letztendlich Innovation und Zusammenarbeit für den praktischen Einsatz von KI-Agenten in Unternehmen fördern. Bei Interesse gerne melden.

Verweise

- Auto-GPT – Wikipedia

- AutoGPT Installation and Features – AutoGPT

- silhouette photo of group people standing on grass (Bild-Quelle)

- The inside of a hard drive is exposed. (Bild-Quelle)

- Wooden Figure Stones (Bild-Quelle)

- brown wooden dresser with mirror inside white room (Bild-Quelle)

- life is a succession of choices, what is yours? (Bild-Quelle)